什麼是 ASL (AI 安全等級)?人工智慧公司 Anthropic 的負責任擴展政策解析

隨著人工智慧(AI)技術的快速進步,如何確保其安全發展成為業界關注的焦點。Anthropic 在 2023 年 9 月發布了一項名為 ASL(負責任擴展政策,Responsible Scaling Policy) 的新框架,目的是確保 AI 技術的擴展符合安全與道德標準。這項政策不僅影響 AI 的發展方向,也可能為整個產業樹立新的安全規範。

那麼,ASL 究竟是什麼?它如何影響 AI 的未來?本文將深入解析 Anthropic 的 ASL 政策,探討其目標、運作方式及潛在影響。

什麼是 ASL(負責任擴展政策)?

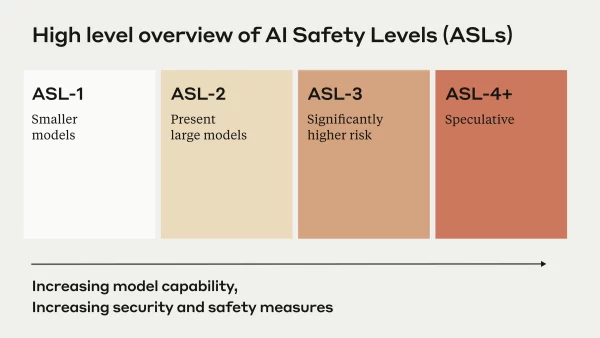

ASL,全名 「Responsible Scaling Policy」,是由 AI 公司 Anthropic 提出的安全規範,旨在隨著 AI 系統的能力增強,確保其發展不會帶來不可控的風險。該政策建立了一套測試標準,根據 AI 的能力表現來決定是否允許進一步擴展,確保技術進步與安全性並行。

ASL 如何運作?三大核心機制

Anthropic 的 ASL 主要透過以下三種方式來運作:

1. 風險評估與測試

ASL 透過 嚴格的測試 來評估 AI 模型的潛在風險,並確保其能力不會超過可接受的範圍。這些測試涵蓋從模型對抗性(Adversarial robustness)到誤用風險(Misuse risks)等多方面的評估。

2. 分級管理與能力門檻

Anthropic 為 AI 設置了一套分級標準,當 AI 達到某個能力門檻時,公司將根據 ASL 框架決定是否允許進一步開發。例如,如果 AI 顯示出可能影響金融市場或國家安全的能力,Anthropic 可能會限制其升級或發布。

3. 外部監管與透明度

為了增加政策的可信度,Anthropic 邀請外部專家監督 ASL 的執行,確保政策不只是企業內部的標準,而是符合更廣泛的道德與安全考量。此外,Anthropic 也強調政策的透明度,定期發布報告以向公眾和監管機構提供資訊。

ASL 對 AI 產業的影響

Anthropic 推出的 ASL 可能會對 AI 產業帶來深遠影響,包括:

- 樹立 AI 安全標準:ASL 可能成為其他 AI 公司的參考範本,促使更多企業採取類似的安全措施。

- 影響 AI 監管政策:隨著政府對 AI 監管日益關注,ASL 的推出可能影響未來的政策制定。

- 提升企業信任度:對 AI 風險感到憂慮的企業和用戶,可能更願意採用遵循 ASL 標準的 AI 產品。

ASL 是 AI 未來發展的重要指引

Anthropic 的 ASL 提供了一種負責任的 AI 擴展策略,試圖在技術發展與安全性之間找到平衡。隨著 AI 變得越來越強大,如何確保其不被濫用、保持透明性,將是產業共同面對的挑戰。ASL 的誕生,不僅讓 Anthropic 成為 AI 安全領域的領導者,也可能為未來 AI 監管提供寶貴的參考依據。

未來,ASL 是否會成為業界標準?這仍有待觀察,但可以確定的是,負責任的 AI 擴展將是不可忽視的議題。

這篇文章 什麼是 ASL (AI 安全等級)?人工智慧公司 Anthropic 的負責任擴展政策解析 最早出現於 鏈新聞 ABMedia。

免責聲明:文章中的所有內容僅代表作者的觀點,與本平台無關。用戶不應以本文作為投資決策的參考。

您也可能喜歡

Tutorial(TUT):關於 AI 驅動區塊鏈教育的 MEME 幣

Glassnode:比特幣調整至新的價格區間,而長期持有者仍不活躍

簡單來說 Glassnode 指出,比特幣市場仍在適應新的價格區間,流動性條件正在收緊,長期持有者仍然不活躍,這導致市場低迷。

Graphite 推出 Dimond AI 驅動的代碼審查代理,以實現更快的編碼速度

簡單來說 Graphite 推出了 Dimond AI 驅動的代碼審查代理,並籌集了 52 萬美元的 B 輪融資來支持專案開發。

BANANAS31USDT 現已上架合約交易和交易BOT